设计师眼中的A/B测试

作者从设计师的角度出发,由浅至深的讲述A/B测试的背景、测试流程以及案例分析等,希望对感兴趣的人有所帮助。

在写这篇文章之前,作者想引用原研哉先生的一句话:“我做这篇分享的初衷,是想让普通人也能看懂。 ”是的,设计的门槛确实很高,但我不想人们因为门槛望而却步,希望本文能对感兴趣的人有所帮助。

课前思考

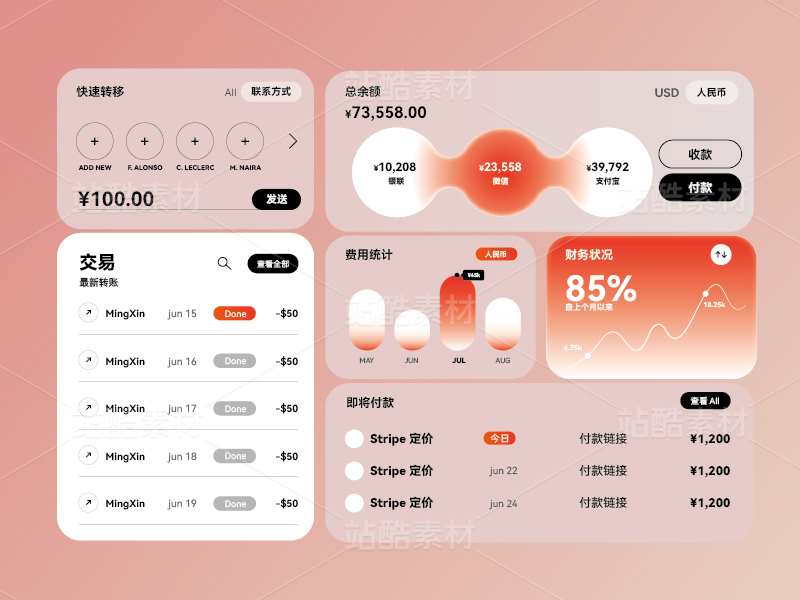

在正式了解A/B测试之前,我们先来看一组图。这是一组首页banner图,由相同的文案不同的视觉风格构成。

设计师为了满足需求方的要求,往往会出几组方案让其选择,那这是A/B测试吗?

......

答案是否定的。

如果由一个人来判断设计的好坏,那这个结论是很主观的。每个人的审美喜好都不一样,不论他否是有经验还是拥有决策权,始终缺乏关键的说服力。

那关键的说服力是什么?

是数据。

在大数据时代,我们经常听到「用数据驱动产品」这句话,那么同样的A/B测试也一定是有数据依据的。

所以A/B测试的核心是数据分析。

A/B测试的背景

A/B测试其实最早应用于生物制药。为了测试药物的疗效,研发人员将药物分成【普通组】和【对照组】给病人服用,通过观测和数据对比来验证药物是否有效。

引入互联网

那A/B测试是如何从生物制药引入到互联网中的?传闻是谷歌在千禧年(2000年)之际进行了他们的第一次A/B测试,当时的目的是搜索结果的数量展示以哪种方案最优,但由于加载时间缓慢,测试的最终结果并不理想。

但这一次的测试可以算是A/B测试在互联网中的首次应用。数据统计,仅在在2011年,谷歌就进行了7000多次A/B测试,此后亚马逊和eBay也开始效仿谷歌进行A/B测试。

什么是A/B测试?

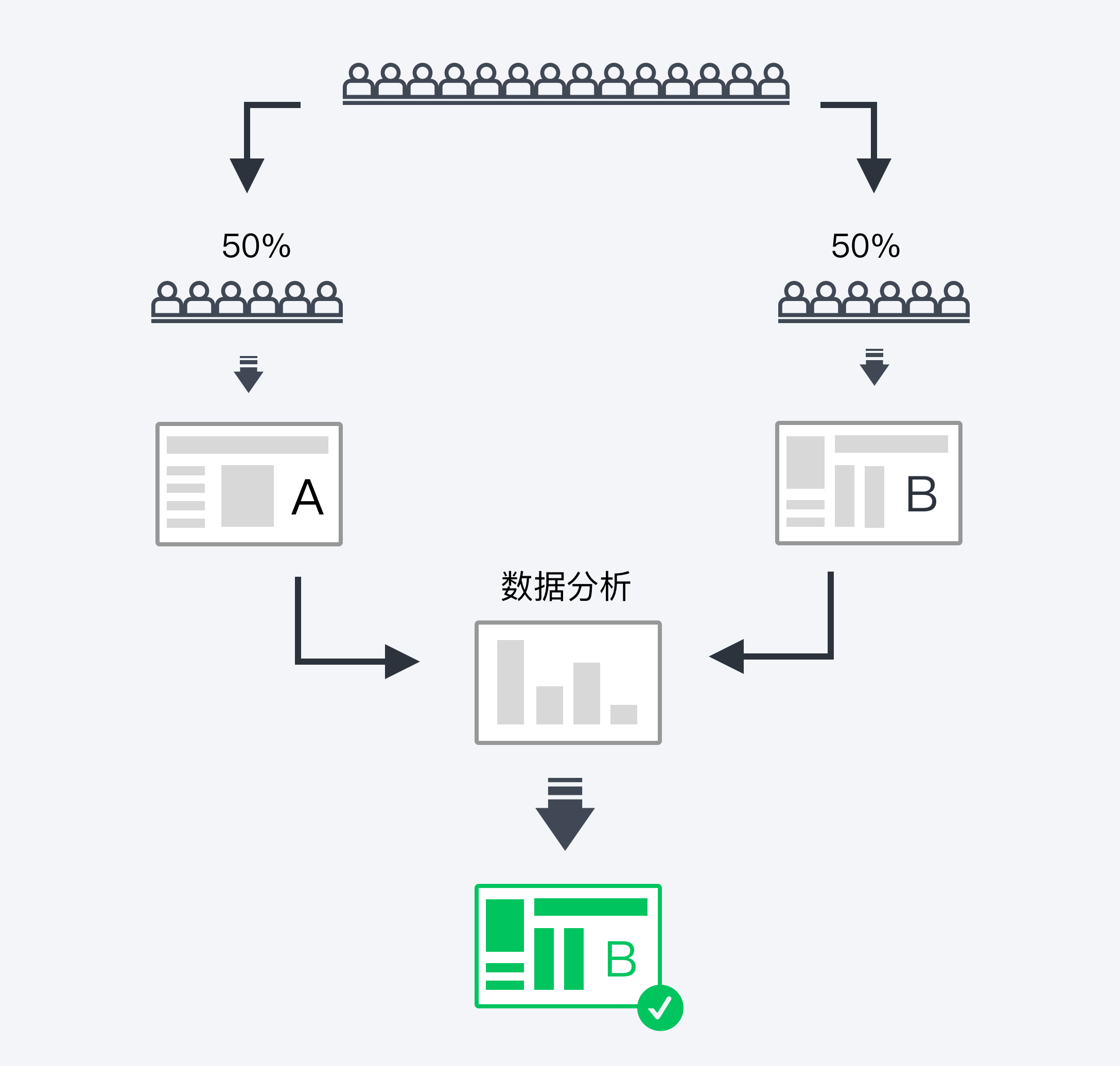

我们先看一张图。

通过图片上的流程,我们就很容易理解。

简单来说,A/B测试就是将测试对象(网页/应用)分成AB两组,让相同数量或样本的用户去访问测试对象,然后监测这两组数据指标,测试结束后去分析这两组数据指标,判断对于我们所关注的核心指标是否有显著的影响,从而选出更好的测试对象版本。

A/B测试能帮我们做什么?

不同的岗位人群,对于A/B测试的目标是不一样的。

一般来说,对于产品主要是产品功能迭代。

帮助产品功能迭代决策使用哪个方案或版本。产品可以利用小部分流量进行A/B测试,在不影响用户体验的同时,从多种方案中找到最佳方案。

对于运营,主要是用户转化优化。

运营通过观测转化指标,计算各个环节的转化率,将最佳的方案发布至线上。

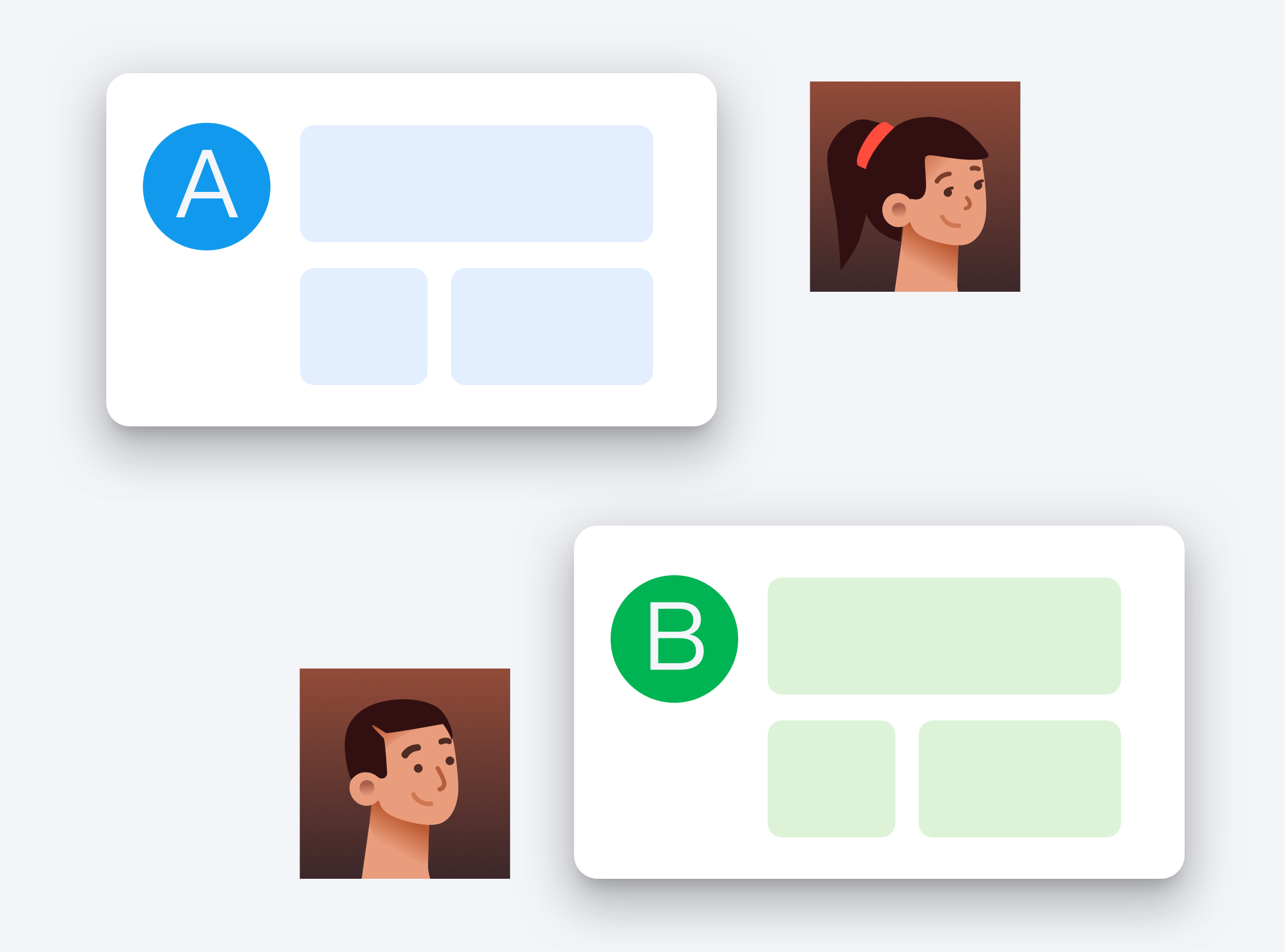

对于设计,主要是UI&交互优化。

UI或交互大改版,可通过A/B测试对比不同交互或视觉下的点击、留存、转化等指标,找到最佳迭代版本。

对于研发,主要是灰度发布。

灰度发布又叫金丝雀发布,起源是矿井工人发现金丝雀对瓦斯气体很敏感,所以矿工会在下井之前先放一只金丝雀到井中,如果金丝雀不叫了,就代表瓦斯浓度高井下有危险。

在灰度发布开始后,先启动一个新版本应用(但不直接将流量切过来),就个版本就是金丝雀。然后测试人员对这个版本进行内部测试,如果没有问题,就将少量的用户流量导进来,然后再观察收集各种数据,跟旧版本进行数据对比,这个对比过程也就是A/B测试。最后将所有流量都切换到新版本上,关闭老版本,灰度发布就完成了。

研发通过灰度发中的A/B测试,对新版本迭代逐步放量,出现问题一键回滚,可以及时止损。

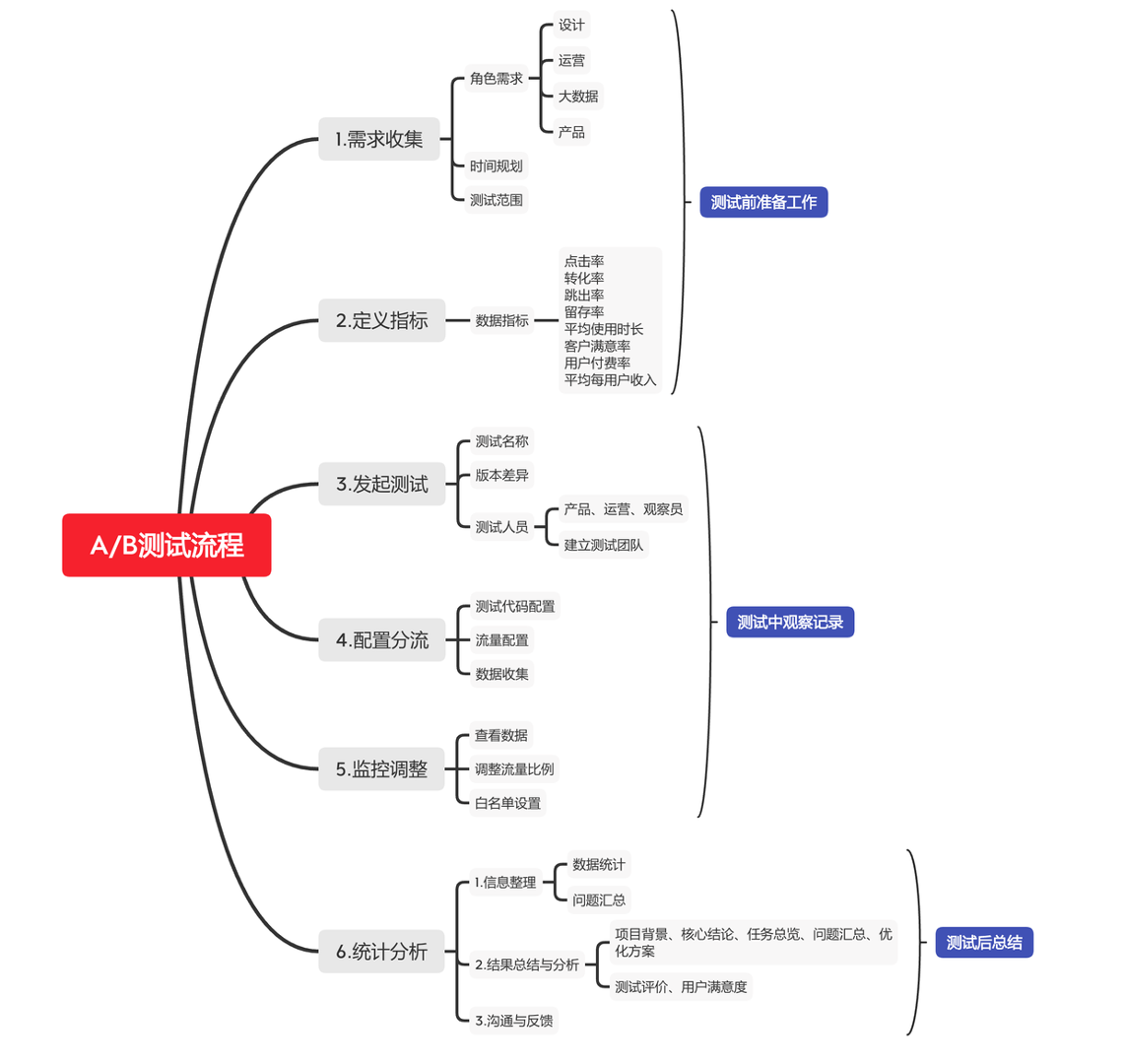

A/B测试的流程

我根据以往的工作经验以及学习参考的资料,整理了A/B测试的流程,一共分为6个步骤。

1.需求收集

2.定义指标

3.发起测试

4.配置分流

5.监控调整

6.统计分析

需求收集

首先我们要收集不同岗位人群的测试需求。

举个例子,

产品想测试:批量下载功能是否高效?

设计想测试:按钮的不同交互能否提升点击率?

运营想测试:banner广告位的位置哪个点击率更高?

数据想测试:不同算法的点击率

我们收集好需求后,还要对时间和测试范围做一个规划。比如,我们确定测试一个banner广告位的点击率,测试周期是14天。

定义指标

接着我们需要定义通过什么数据指标来衡量A/B测试的标准,这一步很关键。需要提前和研发进行沟通,确认能收集到对应数据。

常见的数据指标有:

PV

UV

VV

点击率

跳出率

转化率

留存率

平均使用时长

客户满意率

用户付费率

平均用户收入

举例:

PV(Page View页面浏览量):用户每次对网站中的页面的访问

UV(Unique Visitor独立访客人数):访问网站的一台电脑客户端为一个访客

VV(Visit View用户访问次数):记录所有访客1天内访问了多少次你的网站,从访客来到您的网站到最终关闭网站的所有页面离开,记为1次访问。对于视频网站,VV也是视频播放次数(Video View)的简称

这些数据并不是全部都要获取,关键是取决于你们想对比什么数据。

发起测试

A/B测试一般由产品或运营发起测试,包含测试名称、测试版本差异以及测试人员的确定。测试人员由产品、运营、设计等组成观察员,必要时还可以建立测试团队。

配置分流

由研发人员通过代码进行配置,对用户流量进行配置,对测试对象(网站/应用)进行埋点,对数据进行收集等。

常用的数据监测平台主要有Google Analysis、友盟、百度数据等。

监控调整

在测试的过程中,观察员(产品、运营等)要及时查看数据,根据数据调整用户流量比例,设置白名单等。

统计分析

最后就是数据统计与分析了。研发整理输出数据给观察员,观察员进行问题汇总、统计分析,最后输出测试结果,同步给相关人员。

案例分析

为了便于大家理解并运用A/B测试,我们模拟做一个简单测试流程,用于案例分析。

首先,我们先选取一个测试主题。

常见的A/B测试主题主要有:

用户体验优化

广告投放优化

算法优化

转化率数据指标优化

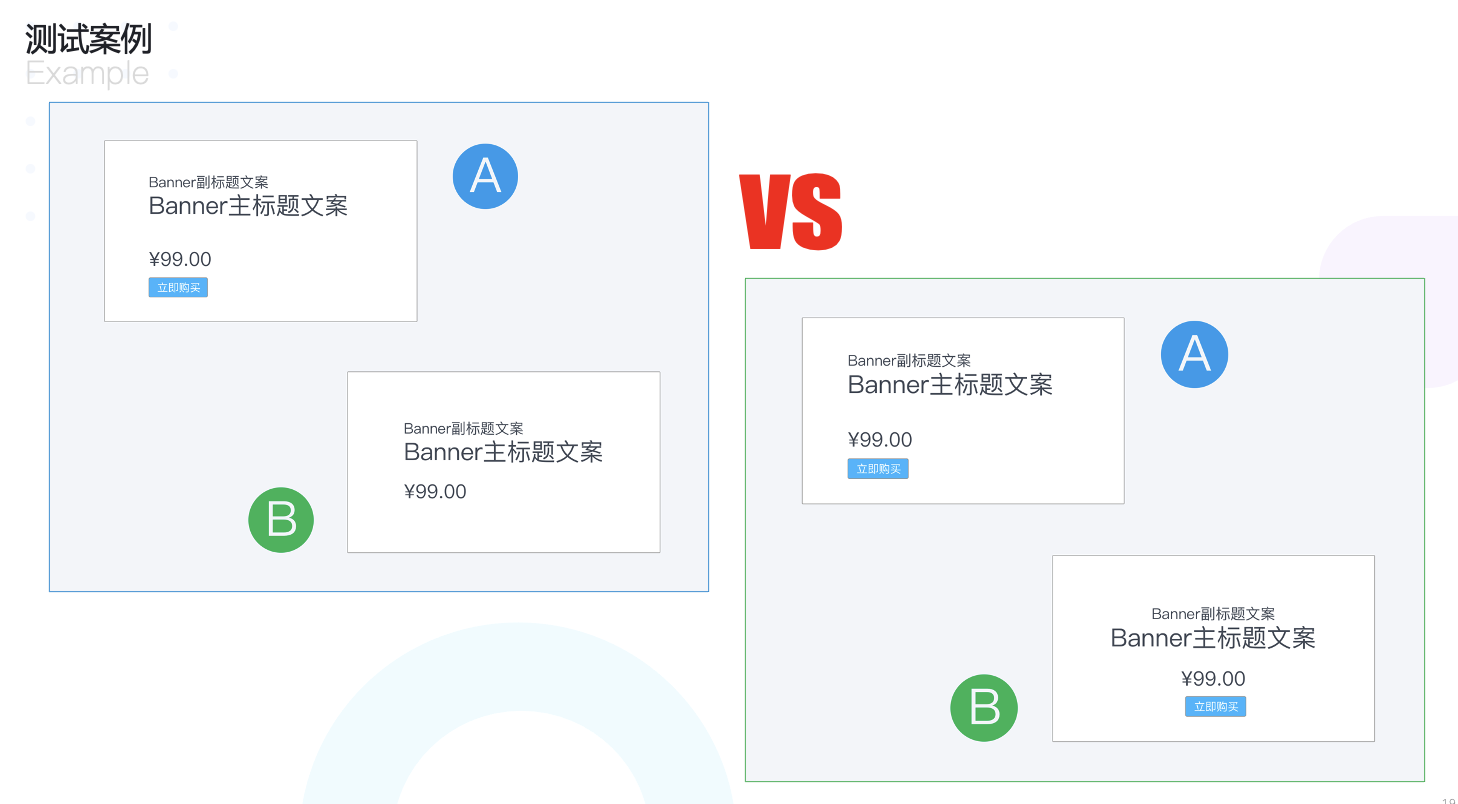

我们这次要做的主题是广告投放优化。以某品牌官网为例,该官网有个很重要的广告位,我们希望提升它的广告位点击率,于是运营和设计师做了几个不同设计排版。

测试1

A方案:广告位文案排列左对齐,同时增加【立即购买】按钮

B方案:广告位文案排列左对齐,无按钮

测试2

A方案:广告位文案排列左对齐,有购买按钮

B方案:广告位文案排列居中对齐,有购买按钮

测试方式

1.A/B两个版本同时在线,利用友盟平台对广告位进行埋点

2.通过分流工具对用户流量进行划分,保证两个版本用户样本基本一致

测试结果

测试时间:两周

测试流程:

第一周,我们上线测试1的两个方案。通过数据对比我们发现,不论是PV还是UV,A方案(有购买按钮)的广告位点击率要高于B方案(无购买按钮)。

第二周,我们上线了测试2的两个方案,通过数据对比我们发现,A方案(左对齐)的广告位点击率要高于B方案(居中对齐)。

最终,我们确定了广告位的设计是采用文案左对齐+购买按钮的设计。

注:以上数据均为作者模拟,并非商品的真实数据。